OpenAI的GPT-oss模型在开源后,吸引了很多开发者对其进行深入剖析。通过一些特殊算法、参数检测以及与模型的互动,GPT-oss的中文训练数据呈现出一种“脏”的现象。

数据分析方法

研究人员采用了一系列方法来探究训练数据中隐藏的内容。

- 权重分析:通过查看模型参数中的“权重”,研究人员能够识别出哪些词在模型中占据更重要的地位。这些高频词汇包括大量的脏话、广告词以及其他敏感词。

- 直接询问模型:通过向模型输入一些特定的词汇,观察其反应,可以确定这些词是否在训练中被频繁使用。

- 词汇排行与分组:将识别出的词汇按照频率和性质进行排序,以找出哪些是属于脏话、广告或特殊词组。

- 测试网络热词和怪词:通过输入一些无意义或敏感的网络词汇,测试模型对这些词汇的熟悉程度。

敏感词和无效词的影响

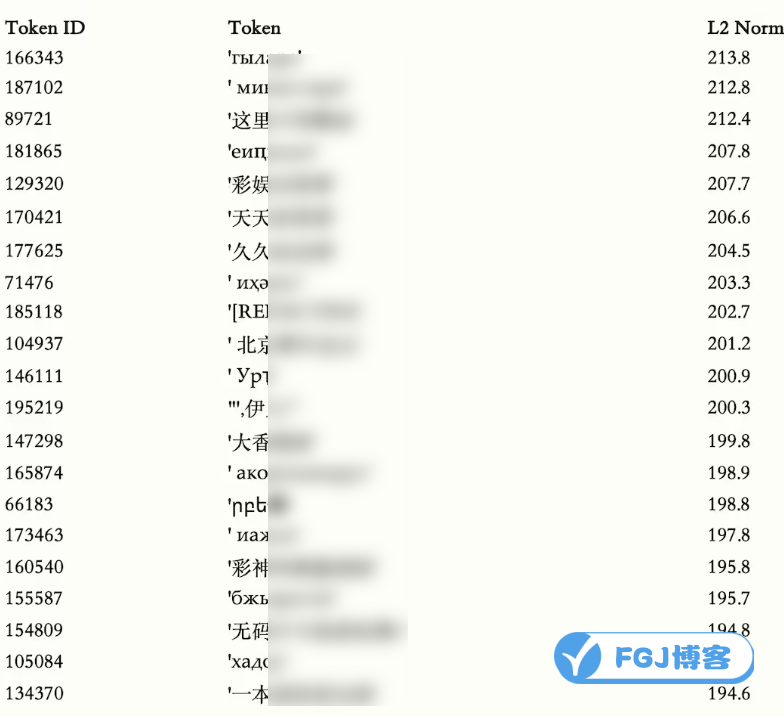

下表展示了一些敏感词在模型中的存在情况排行:

不难发现,这些“脏”词每次被加载至模型内部进行推理,无论用户的输入是什么,都会影响到输出内容。

识别与过滤的挑战

在机器学习领域,模型对某些词有反应说明该词可能是训练数据的一部分。这种现象称为“成员推断”。通过与不同版本的GPT模型对比测试,“敏感token”的识别能力差异明显。这意味着训练数据的来源广泛且复杂,比如来自GitHub的公开仓库,包含大量非ASCII标记的内容。

DeepSeek模型的处理方式

值得注意的是,DeepSeek开源模型在训练前进行数据过滤、清洗和人工审核,以最大程度减少敏感内容的进入。这表明,虽然目前中文互联网上的公开内容质量并未显著提升,但通过严格的数据处理策略,可以有效降低垃圾信息的影响。

本站资源来源于网络,仅限用于学习和研究目的,请勿用于其他用途。如有侵权请发送邮件至vizenaujmaslak9@hotmail.com删除。:FGJ博客 » OpenAI的中文训练数据怕是有点脏

WitNote – 开源的本地笔记软件

WitNote – 开源的本地笔记软件 Edge浏览器新增网站级扩展开关功能:一键管理所有扩展权限

Edge浏览器新增网站级扩展开关功能:一键管理所有扩展权限 Nano Banana 2 – 2025年最新AI绘图神器

Nano Banana 2 – 2025年最新AI绘图神器 开源看图工具jarkViewer:支持多格式和读取AI图片提示词

开源看图工具jarkViewer:支持多格式和读取AI图片提示词 Karakeep – 综合性网络书签工具【开源】

Karakeep – 综合性网络书签工具【开源】 WisPaper:AI学术科研助手

WisPaper:AI学术科研助手